Тестовая система

Процессор: AMD Athlon 64 FX-60 @ 2,80ГГц (Dual core CPU),

AMD Athlon 64 FX-57 @ 2,80 ГГц (Single core CPU)

Материнская плата: MSI K8N SLI (nForce 4 SLI)

Оперативная память: 2х512 Мбайт DDR 400 Corsair 2-2-2-5

Блок питания: OCZ 520W

ОС и драйверы

Windows XP Professional SP2; nVidia nForce4 Platform Driver 6.39; DirectX 9.0c End User Runtime; Catalyst 6.1 и ForceWare 81.98

Эксперимент

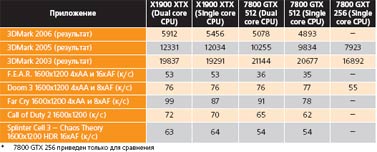

В итоге получилась довольно интересная картинка.Во-первых, «оптимизации под двухъядерность» действительно принесли в ряде приложений весьма ощутимые плоды, выразившиеся примерно в 10—15-процентном приросте производительности в 3Dmark 2006 и Far Cry. Причем если с 3Dmark ситуация не вполне понятна (возможно, разработчики Futuremark приложили здесь свою руку), то с Far Cry — однозначна: эта игра многопоточность до сих пор не поддерживает, и существенный прирост производительности при переходе к двухъядерным процессорам в ней — это в чистом виде эффект новых драйверов. nVidia каких-либо комментариев по поводу своих «оптимизаций», к сожалению, не дает (и, что еще хуже, пользователи в некоторых ситуациях жалуются на нестабильную работу «оптимизированных» драйверов, вплоть до необходимости эти оптимизации через реестр отключать), а вот представители ATI охотно поясняют, что, по сути, основные их оптимизации сводятся к разнесению потоков видеодрайвера (обрабатывающего «сырые» данные, передаваемые ему через Direct3D— или OpenGL-интерфейсы, и отправляющего их на ускоритель) и потока игры по разным процессорам. Far Cry традиционно славен огромными объемами используемой в этой игре «геометрии», а потому, по видимости, их обработка действительно занимает настолько существенное время, что подобное «распараллеливание» дает ощутимый прирост. Однако в остальных случаях, как нетрудно видеть, от существующих «оптимизаций» ни вреда, ни толку, в общем-то, никакого.

Для некоторых игр, и, в частности, Quake 4 и Call of Duty 2, существуют специальные патчи, вносящие в эти игры «врожденную» поддержку многопоточности. Поскольку здесь речь заходит уже не о тривиальном «разделении» драйвера и игры по разным процессорам, а о более интеллектуальном распределении между процессорами различных подсистем одной игры, то и прирост производительности здесь стабильнее и выше — до 40% (!). Но здесь, к сожалению, следует упомянуть одно «но»: происходит это далеко не во всех игровых ситуациях и, к сожалению, наибольший прирост достигается на наиболее простых и потому «быстрых» игровых сценах, которые, в общем-то, ускорять и не обязательно. И объяснение этому эффекту довольно простое: основной «тормоз» в играх — это графический ускоритель, а до тех пор, пока 80% времени процессор ожидает, пока ускоритель выведет очередной кадр на экран, получить более чем 1/(1 — (1-80%) / 2) ~ 11% прироста производительности, увы, даже в идеальном случае невозможно. А чем проще сцена — тем меньше времени съедает видеокарта и тем больше прирост производительности. И, к сожалению, пока при разработке игр основной упор делается на «графику», эта ситуация к лучшему не изменится. К примеру, в российском «Периметре», многопоточность довольно эффективно используется для параллельной обработки повреждений и изменений игрового мира. Но сегодняшние стратегии и так не могут пожаловаться на недостаточную производительность машин игроков, а когда вы в последний раз видели шутер, где можно было бы соорудить не то что дырку в стене дома, а хотя бы воронку в земле от взрыва снаряда?

Одним словом, определенная польза от перехода на двухъядерность в играх, безусловно, уже появляется; однако, в общем и целом — не оправдывает затрачиваемых на нее средств (проще уж видеокарту купить подороже). Отсюда и минимальная разница в цене между FX-57 и FX-60. Однако критиковать AMD за «преждевременный переход Athlon 64 FX на двухъядерность», думаю, глупо — в конце концов, лишние 6—8% сугубо потенциального преимущества FX-57 в играх явно не стоят огромных преимуществ, предоставляемых FX-60 во всем остальном, включая типовую повседневную работу. Другой вопрос, что хотелось, в принципе, большего, чем скромное увеличение тактовой частоты топового двухъядерного решения на 8,3%.

С GeForce 7800 GTX 512 Mбайт все проще — она везде и всюду сильно (до 40%) опережает своего предшественника, чего и следовало ожидать от «разогнанного» решения. Это очень хорошая видеокарта, но ее бывшее лидерство уже утрачено, массовое распространение — не светит, а шум и тепловыделение лишь немногим меньше, чем у X1900. Одним словом, в «королях горы» может ходить только один, и период «царствования» 7800 GTX 512, отлично расходившегося еще пару месяцев назад, позади.

Благодарим компанию AMD за предоставление тестового набора на базе процессора FX-60 и компанию MSI за материнскую плату K8N SLI.

«Компьютерры» : далеко не все читатели знакомятся с «терровскими» текстами именно через Интернет, а из тех, кто знакомится, — далеко не все дают себе труд «выставить оценку» и нажать на голосовальную кнопку. Кроме того, кажется, в этот рейтинговый проект иной раз забираются и разного рода фанаты, — иначе как можно объяснить устойчивый дрейф между первым и вторым местом Георгия Кузнецова — журналиста, которого я ставлю очень высоко, но который не печатался в «Компьютерре» без малого уже восемь лет? И тем не менее какие-то интересные тенденции из этого рейтинга почерпнуть удается.

Например, хоть меня несколько и удивляет факт, что из моих «Огородов» вот уже давно высший рейтинг имеет опубликованный в ноябре 2004-го, то есть почти полтора года назад, «Ink Link», фактом он и остается. Речь там шла об одноименной, произведенной американской компанией Seiko Instruments (не путать с Seiko Epson Corporation!) координатной ручке, движения которой по листу бумаги, зажатому в клипсу-детектор, фиксировались и передавались в графическом виде на компьютер, обычный или даже карманный. По главной идее похожая на графический планшет, ручка имела перед ним целый ряд преимуществ. Во-первых, оставляла на бумаге чернильные следы, так что, создавая какую-нибудь схему, набросок или рукописный текст, их автор автоматически, без использования редакторов и принтеров, имел в запасе, что называется, твердую копию, — и это могло пригодиться где-нибудь в техподдержке или на семинарах. (Правда, такими способностями обладают и некоторые из графических планшетов, но — исключительно посредством специальных стилусов, которые стоят чуть ли не дороже Ink Link’а целиком). Во-вторых, клипса-детектор меньше любого, даже миниатюрного планшета и легко умещается в нагрудном кармане рубашки (производители поместили Ink Link в эдакий очешник). Ну и в-третьих, наконец, Ink Link был в несколько раз дешевле приличного планшета…

Например, хоть меня несколько и удивляет факт, что из моих «Огородов» вот уже давно высший рейтинг имеет опубликованный в ноябре 2004-го, то есть почти полтора года назад, «Ink Link», фактом он и остается. Речь там шла об одноименной, произведенной американской компанией Seiko Instruments (не путать с Seiko Epson Corporation!) координатной ручке, движения которой по листу бумаги, зажатому в клипсу-детектор, фиксировались и передавались в графическом виде на компьютер, обычный или даже карманный. По главной идее похожая на графический планшет, ручка имела перед ним целый ряд преимуществ. Во-первых, оставляла на бумаге чернильные следы, так что, создавая какую-нибудь схему, набросок или рукописный текст, их автор автоматически, без использования редакторов и принтеров, имел в запасе, что называется, твердую копию, — и это могло пригодиться где-нибудь в техподдержке или на семинарах. (Правда, такими способностями обладают и некоторые из графических планшетов, но — исключительно посредством специальных стилусов, которые стоят чуть ли не дороже Ink Link’а целиком). Во-вторых, клипса-детектор меньше любого, даже миниатюрного планшета и легко умещается в нагрудном кармане рубашки (производители поместили Ink Link в эдакий очешник). Ну и в-третьих, наконец, Ink Link был в несколько раз дешевле приличного планшета…