Страница:

Из практических советов — если вам по какой-то причине важен объем винчестера (например, для нужд видеомонтажа), обратите внимание, что начиная примерно с 300 Гбайт объем растет гораздо медленнее, чем цена, так что два 250-гигабайтных диска обойдутся дешевле, чем один на 500 Гбайт. К тому же дисков небольшого объема к современной материнской плате можно подключить не один и не два, причем объединив их в массив RAID 0, в котором они будут работать гораздо быстрее, чем диск на 500 Гбайт. Правда, если один из дисков сломается (что вероятнее, нежели в случае одного большого диска), то погибнет весь массив.

Впрочем, даже если вы предпочтете один винчестер большой емкости массиву из нескольких, то нет никаких гарантий, что в один прекрасный день и он не выйдет из строя. Последние несколько лет крупных скандалов, связанных с каким-нибудь заводским дефектом, приводившим к массовому отказу HDD, не было, однако единичные случаи отказа встречаются у всех производителей — и у Seagate, и у Samsung, и у Maxtor, и у Hitachi, и даже в хваленой серии WD Raptor с ее пятилетней гарантией. Поэтому традиционным советом долгое время было собирать для HDD, на которых хранится критически важная информация, избыточные массивы RAID 1, в которых информация на двух (или нескольких) дисках дублируется. RAID 1 тоже позволяет получить кое-какой выигрыш в производительности (за счет того, что данные можно одновременно читать с двух дисков, причем начиная с того, с которого это сделать удобнее), однако если в RAID 0 объем задействованных дисков складывается, то в RAID 1 — равен объему одного диска, задействованного в массиве. Учитывая дешевизну гигабайта дискового пространства, это не такая большая проблема, но сегодня появилось более изящное решение — RAID 5. Энное количество дисков объединяется в массив по тому же принципу, что и RAID 0 (то есть хранимая в массиве информация равномерно распределяется по дискам), но с одним дополнительным диском, на котором записываются биты четности для записанной на остальные диски информации.1 Четность — простейший код коррекции ошибок, но его вполне достаточно, чтобы при отказе любого из дисков, входящих в RAID 5, данные, записанные в массиве, можно было восстановить. За счет этого, например, можно подключить к материнской плате на чипсете nForce 570 шесть винчестеров и получить массив, соответствующий по объему и быстродействию массиву из пяти дисков, объединенных в RAID 0, но при этом не теряющий информацию и продолжающий работать в случае единичной поломки. Проще говоря, из массива на шесть дисков можно вынуть любой диск, и ничего страшного не случится, массив продолжит работать как ни в чем не бывало. Главное, чтобы, пока вышедший из строя или отключенный диск не будет заменен, не сломался еще один диск в массиве, потому что два пропуска в данных код четности уже не исправляет. Однако вероятность того, что почти одновременно сломаются два жестких диска, в сотни раз меньше по сравнению с вероятностью одиночного отказа. Кроме того, даже если заменить вышедший из строя диск нечем, теоретически RAID 5 можно просто «ужать», создав на его месте новый массив уже из пяти дисков, на 25% меньшего объема и скорости, но зато снова устойчивого к отказам. При цене 80-гигабайтных моделей в районе $50 создание даже самого маленького RAID5-массива на 240 Гбайт из четырех HDD выглядит довольно интересной идеей. Несмотря на вдвое большую стоимость по сравнению с одиночным 250-гигабайтным диском такая конструкция защищена от поломок и потери информации и обладает гораздо более высокой скоростью. Для дисков большего объема (скажем, массива из четырех дисков на 250 Гбайт, который обойдется в $400) картина получается еще более радужная, поскольку одиночный диск того же объема, более медленный и ненадежный, стоит $450. Одно лишь плохо (помимо высоких цен) — далеко не в каждый корпус можно установить 4—6 дисков, обеспечив им питание и охлаждение.

Впрочем, даже если вы предпочтете один винчестер большой емкости массиву из нескольких, то нет никаких гарантий, что в один прекрасный день и он не выйдет из строя. Последние несколько лет крупных скандалов, связанных с каким-нибудь заводским дефектом, приводившим к массовому отказу HDD, не было, однако единичные случаи отказа встречаются у всех производителей — и у Seagate, и у Samsung, и у Maxtor, и у Hitachi, и даже в хваленой серии WD Raptor с ее пятилетней гарантией. Поэтому традиционным советом долгое время было собирать для HDD, на которых хранится критически важная информация, избыточные массивы RAID 1, в которых информация на двух (или нескольких) дисках дублируется. RAID 1 тоже позволяет получить кое-какой выигрыш в производительности (за счет того, что данные можно одновременно читать с двух дисков, причем начиная с того, с которого это сделать удобнее), однако если в RAID 0 объем задействованных дисков складывается, то в RAID 1 — равен объему одного диска, задействованного в массиве. Учитывая дешевизну гигабайта дискового пространства, это не такая большая проблема, но сегодня появилось более изящное решение — RAID 5. Энное количество дисков объединяется в массив по тому же принципу, что и RAID 0 (то есть хранимая в массиве информация равномерно распределяется по дискам), но с одним дополнительным диском, на котором записываются биты четности для записанной на остальные диски информации.1 Четность — простейший код коррекции ошибок, но его вполне достаточно, чтобы при отказе любого из дисков, входящих в RAID 5, данные, записанные в массиве, можно было восстановить. За счет этого, например, можно подключить к материнской плате на чипсете nForce 570 шесть винчестеров и получить массив, соответствующий по объему и быстродействию массиву из пяти дисков, объединенных в RAID 0, но при этом не теряющий информацию и продолжающий работать в случае единичной поломки. Проще говоря, из массива на шесть дисков можно вынуть любой диск, и ничего страшного не случится, массив продолжит работать как ни в чем не бывало. Главное, чтобы, пока вышедший из строя или отключенный диск не будет заменен, не сломался еще один диск в массиве, потому что два пропуска в данных код четности уже не исправляет. Однако вероятность того, что почти одновременно сломаются два жестких диска, в сотни раз меньше по сравнению с вероятностью одиночного отказа. Кроме того, даже если заменить вышедший из строя диск нечем, теоретически RAID 5 можно просто «ужать», создав на его месте новый массив уже из пяти дисков, на 25% меньшего объема и скорости, но зато снова устойчивого к отказам. При цене 80-гигабайтных моделей в районе $50 создание даже самого маленького RAID5-массива на 240 Гбайт из четырех HDD выглядит довольно интересной идеей. Несмотря на вдвое большую стоимость по сравнению с одиночным 250-гигабайтным диском такая конструкция защищена от поломок и потери информации и обладает гораздо более высокой скоростью. Для дисков большего объема (скажем, массива из четырех дисков на 250 Гбайт, который обойдется в $400) картина получается еще более радужная, поскольку одиночный диск того же объема, более медленный и ненадежный, стоит $450. Одно лишь плохо (помимо высоких цен) — далеко не в каждый корпус можно установить 4—6 дисков, обеспечив им питание и охлаждение.

Что касается корпусов — последнего компонента платформы, то гоняться за особенно мощными моделями даже при сборке дорогого компьютера нет смысла. Блок питания на 300—350 Вт легко «потянет» систему начального и среднего ценового диапазона, а на 350—460 Вт — навороченную, с двухъядерным процессором, мощной видеокартой или пресловутыми четырьмя HDD. Лучше обратите внимание на то, чтобы у БП был 24-контактный (а не устаревший 20-контактный) разъем питания: это, во-первых, признак того, что блок питания действительно сумеет полностью выдать заявленную мощность, а во-вторых, это уже достаточно актуально для некоторых материнских плат. Из примеров хороших корпусов упомяну Ascot 6AR и Chieftec; из «среднего звена» — Foxconn и Inwin; из дешевых, но пока меня не подводивших, — Microlab.

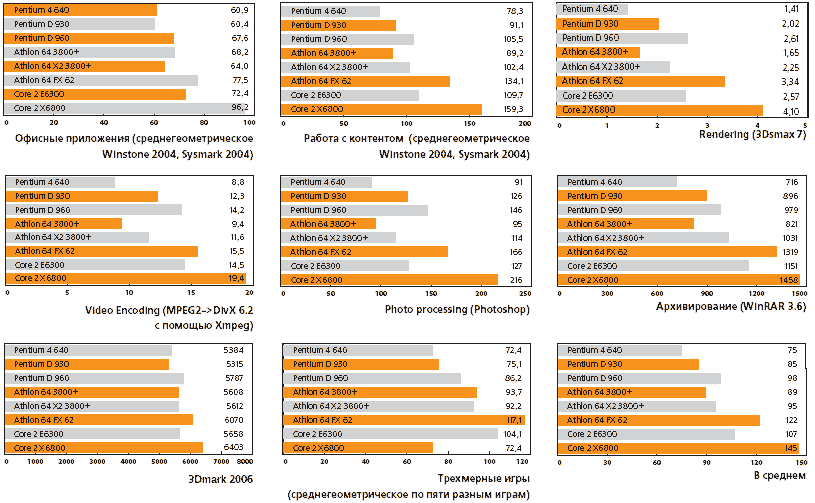

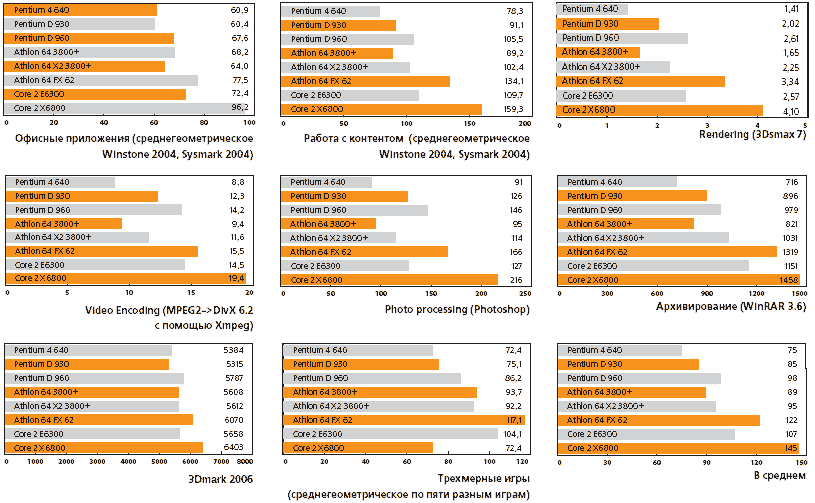

Первый, «особенно безнадежный» случай в лице сложнейшего шедевра вычислительной техники, коим является процессор Pentium 4 в частности и архитектура NetBurst вообще, разгромно проигрывает Core 2 примерно по той же причине, по какой сорокатонный танк с тысячесильным газотурбинным двигателем никогда не догонит обыкновенную легковушку. Схемотехника процессора и заложенные в нее идеи великолепны, многие из них, возможно, опередили свое время, но при всем колоссальном потенциале NetBurst «слишком тяжела» для того, чтобы «быстро ездить». Использованные в ней решения чересчур сложны — а при нынешних микромасштабах кристалла где сложность, там и большой расход энергии. В результате архитектура работает и на 6 ГГц, и вполне пригодна для обещанных нам 10 ГГц, да вот беда — через нее необходимо пропускать такой поток энергии, который, во-первых, придется снимать с процессора криогенной установкой, а во-вторых, даже решив проблему с охлаждением, мы столкнемся с тем, что при столь мощном токе потребления в существующих дизайнах материнских плат начиная с какого-то момента попросту не удается обеспечить достаточно стабильное энергопитание процессора. Pentium 4 на частоте пять-семь-восемь гигагерц, на которые он изначально был рассчитан, был бы чрезвычайно впечатляющим процессором, но увы — «гладко было на бумаге…». Возникает «тепловой тупик».

Первый, «особенно безнадежный» случай в лице сложнейшего шедевра вычислительной техники, коим является процессор Pentium 4 в частности и архитектура NetBurst вообще, разгромно проигрывает Core 2 примерно по той же причине, по какой сорокатонный танк с тысячесильным газотурбинным двигателем никогда не догонит обыкновенную легковушку. Схемотехника процессора и заложенные в нее идеи великолепны, многие из них, возможно, опередили свое время, но при всем колоссальном потенциале NetBurst «слишком тяжела» для того, чтобы «быстро ездить». Использованные в ней решения чересчур сложны — а при нынешних микромасштабах кристалла где сложность, там и большой расход энергии. В результате архитектура работает и на 6 ГГц, и вполне пригодна для обещанных нам 10 ГГц, да вот беда — через нее необходимо пропускать такой поток энергии, который, во-первых, придется снимать с процессора криогенной установкой, а во-вторых, даже решив проблему с охлаждением, мы столкнемся с тем, что при столь мощном токе потребления в существующих дизайнах материнских плат начиная с какого-то момента попросту не удается обеспечить достаточно стабильное энергопитание процессора. Pentium 4 на частоте пять-семь-восемь гигагерц, на которые он изначально был рассчитан, был бы чрезвычайно впечатляющим процессором, но увы — «гладко было на бумаге…». Возникает «тепловой тупик».

Проблемы архитектуры K8, которая, в отличие от NetBurst, использует очень простые и изящные схемы вместо навороченных монстров вроде отдельных функциональных блоков, работающих внутри ядра на удвоенной частоте, диаметрально противоположны проблемам, с которыми столкнулась Intel. Если инженеры последней, грубо говоря, пострадали за то, что были «слишком умными» и погнались за лучшим в ущерб хорошему, то в истории разработки K8 остро ощущается огромный разрыв между тем, какие средства расходует на R&D Intel и какие расходы на разработки может себе позволить больше озабоченная проблемой выживания AMD. Core 2 производится по 65-нм технологическому процессу, Athlon 64 — по 90-нм, причем чем дальше, тем разрыв в возможностях Intel и AMD больше. Там, где в Intel параллельно работают две-три команды над разными вариантами процессоров, команда AMD занята совершенствованием одного; там, где Intel успевает выкатить три степпинга, AMD обновляет два, и т. д. При таком соотношении сил AMD просто не имеет права на серьезную ошибку, равно как и на смелый эксперимент, — и в итоге продвигается вперед маленькими осторожными шажками. Причем по иронии судьбы, похоже, именно такой «маленький и неспешный» метод работает лучше всего: Core 2, в отличие от Pentium 4, тоже «вырос» не сразу, а медленно и постепенно, еще от первых Pentium Pro к Pentium II, Pentium III, Pentium M и Core «Yonah». Однако вечно играть на ошибках соперника таким образом невозможно — что мы нынче и наблюдаем.

Что касается Intel Core 2 Duo, я не стану принижать его возможности и говорить, что это простой или неинтересный процессор. Израильская команда разработчиков великолепно доработала то, что было создано их предшественниками, практически «вылизав» кристалл настолько, насколько вообще было возможно. Огромная производительность оперативной памяти и схемы «умной» предвыборки, в 98% случаев заранее угадывающих, какие данные потребуются в следующий момент. Чрезвычайно быстрая кэш-память второго уровня, разделяемая между ядрами, и очень быстрые и подключенные по широким шинам кэши первого уровня. Целых три функциональных устройства, каждое из которых реализует все операции с упакованными 128-битными операндами SSE (это могут быть четыре 32-битных или два 64-битных числа) всего за один такт. Нигде, насколько мне известно, раньше не применявшаяся новаторская система обработки микроинструкций, записывающих данные в оперативную память. Интересная реализация декодирования x86-инструкций, позволяющая превращать две инструкции в одну микрооперацию. И — что поражает больше всего — практическое отсутствие «узких мест». Фактически из архитектуры P6, которая неявно лежит в основе Core 2, разработчики «выжали» все что можно. AMD, несмотря на то что ее K8 в принципе гораздо перспективнее P6, о таком остается только мечтать, — многие ее «узкие» места давно известны, но не «расширяются» годами.

Впрочем, не подумайте, что я исполняю по архитектуре K8 похоронный марш. Хотя, как я уже сказал, AMD не имеет права на ошибку, рискованные (и революционные) скачки, будучи прижатой к стенке, она все же совершает. В будущем году AMD обещает выпустить значительно улучшенную версию K8, которая (особенно если с 65-нм технологическим процессом все пойдет гладко) сможет сразиться с Core 2 на равных. А затем настанет черед ответного хода Intel, и корпорация, по слухам, уже сейчас «кует» что-то принципиально новое (главное, чтобы инженеры снова не увлеклись и не соорудили второй Pentium 4). Вопреки скепсису последних лет, потенциал для увеличения производительности отдельного процессорного ядра (во всяком случае, в подходе AMD) на ближайшую пятилетку прослеживается явно.

Что же касается дня сегодняшнего, то AMD к концу года надеется (благодаря Fab 36 в Дрездене и заключенному с Chartered Semiconductors производственному соглашению) значительно увеличить свою долю на рынке, продавая процессоры хоть и гораздо дешевле, но зато и в гораздо больших количествах.

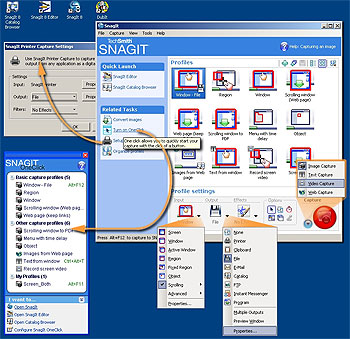

SnagIt. Для кого-то это малопонятный в своей навязчивости 13-мегабайтный заменитель клавиши Print Screen; для других — «виртуальный цифровой фотоаппарат» со встроенной системой распознавания текста. Я же использую такую разностороннюю грабилку экрана для создания макетов графических интерфейсов новых программ из «сфотографированных» частей интерфейсов существующих. А служба поддержки одного известного промышленного софта устанавливает SnagIt в автозагрузку клиентских машин и больше не задает пользователям сакраментальный вопрос: «Что вы видите на экране?» SnagIt все видит сама и по нажатии горячей клавиши (или по расписанию) отсылает по заданному адресу снимки экрана или рабочего поля.

Что касается корпусов — последнего компонента платформы, то гоняться за особенно мощными моделями даже при сборке дорогого компьютера нет смысла. Блок питания на 300—350 Вт легко «потянет» систему начального и среднего ценового диапазона, а на 350—460 Вт — навороченную, с двухъядерным процессором, мощной видеокартой или пресловутыми четырьмя HDD. Лучше обратите внимание на то, чтобы у БП был 24-контактный (а не устаревший 20-контактный) разъем питания: это, во-первых, признак того, что блок питания действительно сумеет полностью выдать заявленную мощность, а во-вторых, это уже достаточно актуально для некоторых материнских плат. Из примеров хороших корпусов упомяну Ascot 6AR и Chieftec; из «среднего звена» — Foxconn и Inwin; из дешевых, но пока меня не подводивших, — Microlab.

Почему Core 2 лучше всех?

Как вы думаете, что устроено проще — быстрый и экономичный Core 2 Duo или медленный и горячий Pentium D? Это может показаться парадоксальным, но Core 2 Duo действительно проще — при том же объеме кэш-памяти в нем гораздо меньше транзисторов, а площадь кристалла и вовсе почти вдвое меньше. Вместе с тем вычислительная техника — это не человеческие взаимоотношения, где зачастую чем проще, тем лучше. Как же так получается? Я хотел было дать краткий ответ на этот вопрос, но исторический экскурс в принципы, положенные в схему функционирования Pentium III, и в усовершенствования, приведшие к Pentium 4, AMD Athlon и Core 2, разросся до половины темы номера. Вкратце же — дело не столько в «удачности Core 2» как архитектуры, сколько в проблемах его конкурентов.

Проблемы архитектуры K8, которая, в отличие от NetBurst, использует очень простые и изящные схемы вместо навороченных монстров вроде отдельных функциональных блоков, работающих внутри ядра на удвоенной частоте, диаметрально противоположны проблемам, с которыми столкнулась Intel. Если инженеры последней, грубо говоря, пострадали за то, что были «слишком умными» и погнались за лучшим в ущерб хорошему, то в истории разработки K8 остро ощущается огромный разрыв между тем, какие средства расходует на R&D Intel и какие расходы на разработки может себе позволить больше озабоченная проблемой выживания AMD. Core 2 производится по 65-нм технологическому процессу, Athlon 64 — по 90-нм, причем чем дальше, тем разрыв в возможностях Intel и AMD больше. Там, где в Intel параллельно работают две-три команды над разными вариантами процессоров, команда AMD занята совершенствованием одного; там, где Intel успевает выкатить три степпинга, AMD обновляет два, и т. д. При таком соотношении сил AMD просто не имеет права на серьезную ошибку, равно как и на смелый эксперимент, — и в итоге продвигается вперед маленькими осторожными шажками. Причем по иронии судьбы, похоже, именно такой «маленький и неспешный» метод работает лучше всего: Core 2, в отличие от Pentium 4, тоже «вырос» не сразу, а медленно и постепенно, еще от первых Pentium Pro к Pentium II, Pentium III, Pentium M и Core «Yonah». Однако вечно играть на ошибках соперника таким образом невозможно — что мы нынче и наблюдаем.

Что касается Intel Core 2 Duo, я не стану принижать его возможности и говорить, что это простой или неинтересный процессор. Израильская команда разработчиков великолепно доработала то, что было создано их предшественниками, практически «вылизав» кристалл настолько, насколько вообще было возможно. Огромная производительность оперативной памяти и схемы «умной» предвыборки, в 98% случаев заранее угадывающих, какие данные потребуются в следующий момент. Чрезвычайно быстрая кэш-память второго уровня, разделяемая между ядрами, и очень быстрые и подключенные по широким шинам кэши первого уровня. Целых три функциональных устройства, каждое из которых реализует все операции с упакованными 128-битными операндами SSE (это могут быть четыре 32-битных или два 64-битных числа) всего за один такт. Нигде, насколько мне известно, раньше не применявшаяся новаторская система обработки микроинструкций, записывающих данные в оперативную память. Интересная реализация декодирования x86-инструкций, позволяющая превращать две инструкции в одну микрооперацию. И — что поражает больше всего — практическое отсутствие «узких мест». Фактически из архитектуры P6, которая неявно лежит в основе Core 2, разработчики «выжали» все что можно. AMD, несмотря на то что ее K8 в принципе гораздо перспективнее P6, о таком остается только мечтать, — многие ее «узкие» места давно известны, но не «расширяются» годами.

Впрочем, не подумайте, что я исполняю по архитектуре K8 похоронный марш. Хотя, как я уже сказал, AMD не имеет права на ошибку, рискованные (и революционные) скачки, будучи прижатой к стенке, она все же совершает. В будущем году AMD обещает выпустить значительно улучшенную версию K8, которая (особенно если с 65-нм технологическим процессом все пойдет гладко) сможет сразиться с Core 2 на равных. А затем настанет черед ответного хода Intel, и корпорация, по слухам, уже сейчас «кует» что-то принципиально новое (главное, чтобы инженеры снова не увлеклись и не соорудили второй Pentium 4). Вопреки скепсису последних лет, потенциал для увеличения производительности отдельного процессорного ядра (во всяком случае, в подходе AMD) на ближайшую пятилетку прослеживается явно.

Что же касается дня сегодняшнего, то AMD к концу года надеется (благодаря Fab 36 в Дрездене и заключенному с Chartered Semiconductors производственному соглашению) значительно увеличить свою долю на рынке, продавая процессоры хоть и гораздо дешевле, но зато и в гораздо больших количествах.

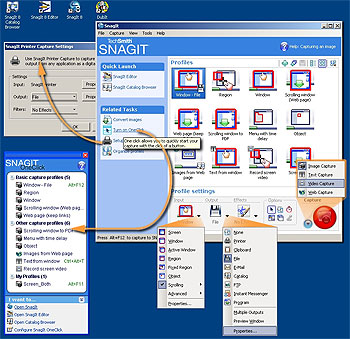

SnagIt. Для кого-то это малопонятный в своей навязчивости 13-мегабайтный заменитель клавиши Print Screen; для других — «виртуальный цифровой фотоаппарат» со встроенной системой распознавания текста. Я же использую такую разностороннюю грабилку экрана для создания макетов графических интерфейсов новых программ из «сфотографированных» частей интерфейсов существующих. А служба поддержки одного известного промышленного софта устанавливает SnagIt в автозагрузку клиентских машин и больше не задает пользователям сакраментальный вопрос: «Что вы видите на экране?» SnagIt все видит сама и по нажатии горячей клавиши (или по расписанию) отсылает по заданному адресу снимки экрана или рабочего поля.

То есть все, что вы видите на экране, SnagIt способна превратить в графический, видео— или текстовый файл, а также снабдить пояснительными аппликациями и простейшей интерактивностью (при сохранении во флэш-формат). Описанная функциональность реализована через множество промежуточных шагов, требующих от пользователя лихорадочного метания курсора от настройки к настройке до полного изнеможения и согласия с установками по умолчанию, называемыми профилями (Capture Profiles).

То есть все, что вы видите на экране, SnagIt способна превратить в графический, видео— или текстовый файл, а также снабдить пояснительными аппликациями и простейшей интерактивностью (при сохранении во флэш-формат). Описанная функциональность реализована через множество промежуточных шагов, требующих от пользователя лихорадочного метания курсора от настройки к настройке до полного изнеможения и согласия с установками по умолчанию, называемыми профилями (Capture Profiles).

Предустановленные профили, отображаемые мнемоническими пиктограммами в главном окне программы, являются простейшими макросами для автоматизации прохождения разветвленного пути «что снимать — куда сохранять». Например, «снимать участок экрана — сохранять в видеофайл с максимальной компрессией». Создание нового профиля для каких-то уж очень специфических задач сводится к сохранению под другим именем сделанных пользователем изменений в настройках профиля существующего.

Использование заранее настроенных предустановок (в том числе дополнительных) предполагает выполнение большего числа однотипных принтскринов. Например, сбор ключевых кадров прохождения какой-либо игры. При индивидуальной же обработке и систематизации каждого снимка экрана рационально задействовать входящие в состав дистрибутива растрово-векторный графический SnagIt-редактор и SnagIt-просмотрщик графических файлов. Для них, по задумке разработчиков, главным поставщиком изображений является сам скрин-граббер SnagIt. Но приводить в журнале иллюстрации, где в рабочем поле одной программы изображено сфотографированное с экрана окно другой программы, — путаница уже на уровне описания рекурсии.

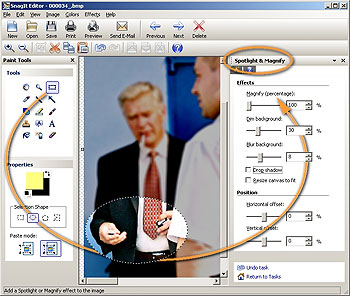

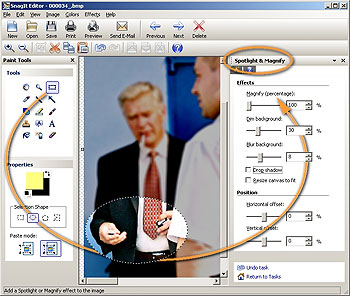

Поэтому, рассматривая «обычную фотографию» в качестве подложки для демонстрации возможностей SnagIt-редактора, самостоятельно оцените его пригодность для вашей деятельности. Например, при оформлении результатов наружного наблюдения частного детективного агентства для акцентирования значимых фрагментов (рис. 2). Обратите внимание, графические инструменты сгруппированы по целевому, а не функциональному назначению. Похвалу в адрес такого подхода сформулировать просто: степень непохожести интерфейса на Photoshop и CorelDrow подчеркивает отличия целевой аудитории SnagIt от когорты профессиональных и примкнувших к ним дизайнеров. «Недизайнерам» работать (в смысле «производить вещи или услуги на продажу») с таким интерфейсом, на мой взгляд, удобнее — почти все элементы иллюстраций к этой статье подготовлены в SnagIt. Однако выполнен сей титанический труд не экспромтом, а после беглого изучения объемистой инструкции . Удивительно, но производитель не вкладывает ее даже в коробочную CD-версию поставки, ограничиваясь 16-страничной Getting Started Guide.

Поэтому, рассматривая «обычную фотографию» в качестве подложки для демонстрации возможностей SnagIt-редактора, самостоятельно оцените его пригодность для вашей деятельности. Например, при оформлении результатов наружного наблюдения частного детективного агентства для акцентирования значимых фрагментов (рис. 2). Обратите внимание, графические инструменты сгруппированы по целевому, а не функциональному назначению. Похвалу в адрес такого подхода сформулировать просто: степень непохожести интерфейса на Photoshop и CorelDrow подчеркивает отличия целевой аудитории SnagIt от когорты профессиональных и примкнувших к ним дизайнеров. «Недизайнерам» работать (в смысле «производить вещи или услуги на продажу») с таким интерфейсом, на мой взгляд, удобнее — почти все элементы иллюстраций к этой статье подготовлены в SnagIt. Однако выполнен сей титанический труд не экспромтом, а после беглого изучения объемистой инструкции . Удивительно, но производитель не вкладывает ее даже в коробочную CD-версию поставки, ограничиваясь 16-страничной Getting Started Guide.