Страница:

Вычисления осуществляются черной дырой чрезвычайно быстро. Фактически время вычислений не зависит (!) от объема обрабатываемой информации, а определяется лишь геометрическими размерами дыры. В теории показано, что время вычислений оказывается равным промежутку времени, который требуется свету, чтобы пройти от одной границы этого «вычислителя» до другой. Так, для килограммовой черной дыры время вычисления равно 10—35 с. Собственно говоря, черная дыра представляет собой самый быстродействующий вычислитель, возможный в нашем Мире.

Ученым пока не очень понятны механизмы «вывода результатов» вычислений черных дыр. И уж совершенно неясно, каким образом программировать вычисления столь экзотического «компьютера». Теоретически известно, что черная дыра способна осуществить любое вычисление, но как приготовить исходное состояние (структуру? последовательность? пространственное или временное распределение?) падающего в черную дыру вещества, чтобы в результате излучение Хокинга «выдало» искомый результат, не знает никто.

Высокая плотность и сложность строения твердых тел порождают огромное количество физических явлений, одновременно «сосуществующих» в объеме материала. Если же добавить сюда ярко выраженные нелинейные свойства твердых сред, приводящие к возникновению взаимовлияний физических явлений, эффектов усиления, генерации, «перекачки» энергии от одних физических процессов к другим, становится понятно, почему внимание исследователей приковано к проблеме создания монолитных твердотельных устройств обработки информации. Большинство ученых и инженеров считают, что именно твердое тело будет основой вычислительных устройств (или сред?) будущего, хотя на пути их создания стоят невероятные трудности математического моделирования физических процессов, протекающих в нем.

Высокая плотность и сложность строения твердых тел порождают огромное количество физических явлений, одновременно «сосуществующих» в объеме материала. Если же добавить сюда ярко выраженные нелинейные свойства твердых сред, приводящие к возникновению взаимовлияний физических явлений, эффектов усиления, генерации, «перекачки» энергии от одних физических процессов к другим, становится понятно, почему внимание исследователей приковано к проблеме создания монолитных твердотельных устройств обработки информации. Большинство ученых и инженеров считают, что именно твердое тело будет основой вычислительных устройств (или сред?) будущего, хотя на пути их создания стоят невероятные трудности математического моделирования физических процессов, протекающих в нем.

Можно выделить два принципиально разных подхода к решению этой задачи: интегральный и функциональный. Реализацией интегрального подхода стали полупроводниковые микросхемы всех современных типов. Функциональный подход породил множество удивительных устройств, нашедших применение в СВЧ-технике, связи и автоматике. Тем не менее теории синтеза твердотельных систем обработки данных до сих пор не существует.

Еще в 60-х годах прошлого столетия в работах исследователей была поставлена задача создания так называемых управляемых континуальных сред, то есть твердых сред, способных непосредственно принимать сигналы извне, обрабатывать содержащуюся в них информацию и выдавать результат. Задача эта оказалась чрезвычайно сложной, и решить ее в общем виде пока не удалось.

Математическое моделирование процессов в твердых телах дало важные сведения касательно того, каким образом «группировать» протекающие там процессы с целью их совместного использования. Стало понятно, что континуальные вычислители легче строить на базе явлений, параметры которых сильно взаимосвязаны, — например, магнитоэлектрических, термомеханических, электронно-механических процессов, фотонно-фононных взаимодействий и т. д. Для формализации синтеза континуальных систем обработки данных предпринимались попытки использовать аппарат теории автоматов и строить графы взаимодействия физических процессов, где каждый элементарный автомат представляет то или иное физическое явление в твердом теле, а ребра графа описывают взаимовлияния.

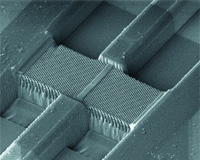

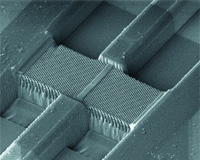

Отдельно стоит упомянуть проекты использования квантовых процессов в твердых телах. Чтобы не связываться с техническими трудностями получения и поддержания экстремально низких температур, многие исследователи занялись разработкой приложений квантовой оптики твердых сред, большинство явлений которой протекают при обычных температурах. Вероятно, самым поразительным результатом этих работ можно считать фотонные кристаллы — искусственно синтезированные твердотельные структуры, обладающие рядом необъяснимых с позиций классической оптики свойств, а также способностью воспринимать и обрабатывать информацию, «закодированную» в параметрах когерентного оптического сигнала. Однако инженерные методики конструирования вычислительных сред на базе фотонных кристаллов еще предстоит создать. — Ю.Р.

Меж нулем и единицей

Вот об этих «других процессах» мы и поговорим.

Кроме измеряемых величин, физические процессы характеризуются также вычисляемыми параметрами, которые недоступны непосредственному измерению прибором и в то же время не всегда сводимы к простым процедурам арифметических манипуляций с измеряемыми величинами. Вычисляемые параметры тоже являются аналоговыми величинами, так как могут непрерывно приобретать любые, сколь угодно мало отличающиеся друг от друга значения. Принципиально важно, что эти величины тоже могут быть носителями информации, подлежащей обработке или запоминанию.

Обратим внимание на одну из богатейших по своим информационным возможностям аналоговую вычисляемую величину — вероятность. Именно то, что вероятность всегда вычисляется и предстает перед нами в виде цифры, маскирует ее аналоговую «сущность».

Отметим также, что вероятность наступления какого-то события (например, переключения триггера) как величина или параметр, характеризующий какой-либо физический процесс, объективно существует даже тогда, когда мы ее не знаем или не можем вычислить. Это очень важное замечание! Постепенное осознание этого обстоятельства позволило в течение тридцатилетней истории работ над вероятностными вычислителями прийти к принципиально новым идеям в этой области; впрочем, об этом поговорим чуть позже.

В 1970-х годах начались активные теоретические исследования и разработки так называемых стохастических вычислительных машин, основанных на вероятностном представлении информации. Переменные и константы в этих аналоговых машинах представлялись вероятностями переключения цифровых логических элементов. Другими словами, информация кодировалась вероятностью, которая в силу своих фундаментальных свойств может принимать непрерывный ряд значений в интервале от 0 до 1.

Архитектура стохастических вычислителей в общем-то повторяла решения, разработанные для аналоговых вычислительных машин: программирование сводилось к набору структурной схемы из решающих блоков, которые в отличие от АВМ были построены не на операционных усилителях, а на логических элементах. Подкупала простота технической реализации вычислителя: замена операций над числами операциями над вероятностями позволила воспользоваться глубокими аналогиями, существующими между аппаратом событийной теории вероятности и принципами математической логики; так, например, операция умножения вероятностей независимых событий формально полностью совпадает с логической операцией конъюнкции, а суммированию вероятностей соответствует операция дизъюнкции. Эти аналогии позволяют считать логические переменные некоторыми случайными событиями, имеющими определенные вероятности появления. С инженерной точки зрения это означает, например, что один логический элемент ИЛИ (дизъюнкция) становится сумматором, а единственный элемент И (конъюнкция) превращается в умножитель!

Этот подход оказался особенно хорош для создания специализированных процессоров, рассчитанных на непрерывное вычисление, предположим, управляющего воздействия в системах управления. Будучи «по природе» аналоговым, такой вычислитель мог решать задачи в реальном времени независимо от объемов вычислений; а будучи цифровым (по элементной базе), он был лишен таких принципиальных недостатков обычных АВМ, как дрейф нуля и шумы операционных усилителей, а также наводок в сигнальных цепях.

Появление широко доступных БИС ПЛИС(Программируемая Логическая Интегральная Схема, еще называется ПЛМ — Программируемая Логическая Матрица) и БМК(Базовый Матричный Кристалл. Обычно отличается от ПЛИС (ПЛМ) наличием на кристалле большого набора базовых элементов ввода-вывода, аналого-цифровых и цифро-аналоговых преобразователей, контроллеров стандартных интерфейсов и т. д.) позволило реализовать на одном кристалле довольно сложные схемы стохастических вычислителей, однако широкого распространения они не получили — сказался главный недостаток этой технологии (как и вообще всех аналоговых технологий): неудобство перепрограммирования и слишком сильная «привязка» исполняемого алгоритма к аппаратной части.

«Принцип арифмометра» победил — наступила эпоха универсальных цифровых вычислителей.

Короче говоря, если в качестве «послезавтрашнего компьютера» вообразить некий «черный ящик», то становится ясно, что дело не в том, на какой элементной базе он построен, а в том, что построено. Какая обрабатывающая среда находится внутри «ящика»?

Вообще, понятие «обрабатывающая среда» довольно абстрактно. Практически это может быть физическая среда, свойства которой дают ей возможность производить вычисления. Кусок стекла, которому придана форма линзы, — уже вычислитель! Он «умеет» вычислять Фурье-преобразование оптических сигналов… Но вот беда: существует так называемый критерий физической реализуемости. В частности, он означает, что не для всякого вычисления можно подобрать (или создать) соответствующую физическую среду. Но даже если критерий физической реализуемости удовлетворяется, практически создать необходимую среду невероятно трудно!

Гораздо продуктивнее моделировать обрабатывающие среды в цифровом виде. Чтобы сделать это, мы должны взять цифровой процессор (любой! хоть арифмометр) и написать для него программу, эмулирующую информационные процессы и структуру нужной нам обрабатывающей среды. Тем самым мы как бы создаем «виртуальную оболочку» вокруг обрабатывающей среды физического уровня, в качестве которой выступает процессор. Что при этом происходит? А вот что: мы преодолеваем критерий физической реализуемости.

Следующий важный вопрос, мимо которого не пройти: что мы хотим получить? Если под «процессором будущего» понимать просто «ну очень быстрый процессор», то, думается, за этим дело не станет. Но, видимо, мы хотим чего-то большего… Чего?

Честный ответ: хотелось бы создать модель себя. По крайней мере, в части восприятия и обработки приходящей извне информации.

А что это значит, если говорить языком технического задания?

Во-первых, быстродействие. Производительность цифровых процессоров зависит от частоты, разрядности и распараллеливания вычислительных процессов. У аналоговых вычислителей таких ограничений нет, но есть много своих специфических «минусов» и существует упоминавшийся выше критерий реализуемости (поскольку аналоговый процессор — это, собственно, физическая обрабатывающая среда «в чистом виде»). А что, если окружить цифровой процессор виртуальной аналоговой «оболочкой»? Из чего ее сделать? Вариант ответа: эта «оболочка» может представлять собой стохастический вычислительный процесс, оперирующий вероятностями, и тогда отпадают ограничения по быстродействию!

Во-вторых, отсутствие необходимости в программировании. Раз нет программирования, следовательно — самообучение? Да. Нейроподобные сетевые структуры. Об их свойствах написаны горы книг, однако сейчас имеет смысл отметить следующее: нейросети — аналоговые обрабатывающие среды, которые мы давным-давно научились реализовывать в качестве «оболочек» над цифровыми процессорами, но… Но при этом нейросети, реализованные в форме программ, оперирующих цифровыми входными сигналами, сами становятся цифровыми, теряя в быстродействии и в качественных показателях. Один из перспективных вариантов разрешения этого противоречия заключается в создании стохастических нейроалгоритмов, позволяющих сохранять аналоговые принципы функционирования нейросетей при цифровом моделировании(Большая работа в этом направлении проводилась в Киевском институте кибернетики им. В. М. Глушкова под руководством академика Н. М. Амосова, в частности, Э. М. Куссулем, А. М. Касаткиным, Л. М. Касаткиной, Т. В. Федосеевой).

В-третьих, отсутствие жестких алгоритмов функционирования — свойство, открывающее возможности адаптивного поведения и динамического целеполагания. Исследования в этом направлении, проводившиеся у нас и за рубежом, показали, что глубинная суть этих процессов с достаточной степенью адекватности описывается лишь аппаратом теории динамического хаоса. Иными словами, чтобы воссоздать «на практике» обрабатывающую среду, обладающую требуемым «поведением», необходимо либо каким-то образом синтезировать ее «в железе», либо смоделировать нужный тип нелинейной динамики. Во втором случае для этого легче всего использовать все те же стохастические нейросети или матрицы вероятностных клеточных автоматов.

По существу, создавая нейросетевую модель нелинейной динамической системы с нужным нам поведением (не детерминированным, а в среднем!), мы тем самым создаем еще одну «оболочку» — уже вторую! — над исходной физической обрабатывающей средой — цифровым процессором.

Гигантский прогресс технических характеристик обычных микропроцессоров и, что особенно важно, накопление огромного арсенала средств разработки — как самих микросхем, так и программного обеспечения всех уровней, — как мне кажется, породили своеобразную «потенциальную яму», «выпрыгнуть» из которой чрезвычайно трудно — нужно много энергии, аналогом которой в данном случае выступают деньги.

Впрочем, всегда есть ненулевая вероятность «туннельного просачивания» сквозь стенки любых потенциальных ям. И для этого, как известно, не нужно много той самой «энергии»!

Практичная теория: день открытых дверей в творческой лаборатории изобретателя

Начну с главного тезиса. Все технические системы, устройства и приборы были кем-то изобретены.

Поэтому, когда мне было предложено рассказать о «технологии изобретания» компьютерных устройств послезавтрашнего дня, да еще основанных на новых физических принципах, я понял, что меня провоцируют. По существу, мне предлагалось поиграть в деловую игру «Назвался груздем…»[Автор является руководителем семинара по ТРИЗ]. В первый момент, каюсь, «взыграло»… Короче говоря, я отбросил тщеславные попытки практически изобрести невиданный процессор, а попытался рассказать о возможных подходах к решению этой задачи, основанных на ТРИЗ — Теории Решения Изобретательских Задач, созданной нашим талантливым соотечественником Генрихом Сауловичем Альтшуллером.

Надо сказать, что изобретательские задачи часто путают с задачами научными, техническими, инженерными или конструкторскими. Если мы, имея комплект чертежей топологии, расчеты технологических параметров и таблицы контрольных значений тестовых сигналов, собираемся изготовить микросхему, то это будет технической задачей. Расчет электронной схемы или теплового режима, предположим, полупроводникового лазера по готовым формулам и методикам — задача инженерная. Поиск этих формул и получение методик — типично научная задача. Поиск компромиссов между функциональностью чипа и его площадью на кристалле — суть задача конструкторская. Решение всех этих задач не связано с преодолением каких-то противоречий. Задача становится изобретательской только тогда, когда возникает необходимость одолеть несовместимость[Альтшуллер Г.С., Творчество как точная наука, М., «Советское радио», 1979 г. См. также: Альтшуллер Г.С., Алгоритм изобретения, М., «Московский рабочий», 1973 г.].

Итак. Какие же действительно несовместимые технические характеристики мы ожидаем встретить в процессоре будущего?

Функциональность и простота в использовании. Преодолением этого противоречия постоянно заняты разработчики программного обеспечения[По Г.С. Альтшуллеру, это конструкторская задача]. И, надо сказать, им это неплохо удается, но… В окружающей природе полно примеров очень функциональных и очень простых в использовании «вычислительных устройств»[Мяукающих, гавкающих, чирикающих и т. п. И говорящих, в том числе. Увы], которые вообще не нужно программировать! Их нужно дрессировать, то есть передавать им представления о том, как им себя вести. А программы такого поведения они создают для себя сами. Это мы возьмем на заметку.

Функциональность и размеры… Сразу вспоминаются квантовые процессоры. Новые физические принципы — налицо, экстремально малые размеры собственно «вычислителя» и — в «нагрузку» — кубометры холодильной техники, лазеров и соленоидов. А почему, собственно, нас так интересуют размеры? Мы что, материал экономим? А если поступим так: выведем в околоземный космос несколько тысяч могучих серверов на спутниках, объединим их в сеть, а на локальные машины возложим лишь отправку «наверх» запросов да исполнение команд. Функциональность — выше некуда, а размеры «клиентов» будут под стать их назначению — думаю, не больше мобильного телефона…

Вы чувствуете, как над нами довлеет инерция мышления?

Это она не позволяет нам представить себе вычислитель, который не вычисляет… Большую систему, которая не занимает места… Сложную и одновременно очень простую… Вот они! Действительные противоречия, составляющие предмет изобретательской деятельности!

Калиновский [ar_ka@ua.fm]

Без лишних деталей

Ученым пока не очень понятны механизмы «вывода результатов» вычислений черных дыр. И уж совершенно неясно, каким образом программировать вычисления столь экзотического «компьютера». Теоретически известно, что черная дыра способна осуществить любое вычисление, но как приготовить исходное состояние (структуру? последовательность? пространственное или временное распределение?) падающего в черную дыру вещества, чтобы в результате излучение Хокинга «выдало» искомый результат, не знает никто.

Твердый орешек

Можно выделить два принципиально разных подхода к решению этой задачи: интегральный и функциональный. Реализацией интегрального подхода стали полупроводниковые микросхемы всех современных типов. Функциональный подход породил множество удивительных устройств, нашедших применение в СВЧ-технике, связи и автоматике. Тем не менее теории синтеза твердотельных систем обработки данных до сих пор не существует.

Еще в 60-х годах прошлого столетия в работах исследователей была поставлена задача создания так называемых управляемых континуальных сред, то есть твердых сред, способных непосредственно принимать сигналы извне, обрабатывать содержащуюся в них информацию и выдавать результат. Задача эта оказалась чрезвычайно сложной, и решить ее в общем виде пока не удалось.

Математическое моделирование процессов в твердых телах дало важные сведения касательно того, каким образом «группировать» протекающие там процессы с целью их совместного использования. Стало понятно, что континуальные вычислители легче строить на базе явлений, параметры которых сильно взаимосвязаны, — например, магнитоэлектрических, термомеханических, электронно-механических процессов, фотонно-фононных взаимодействий и т. д. Для формализации синтеза континуальных систем обработки данных предпринимались попытки использовать аппарат теории автоматов и строить графы взаимодействия физических процессов, где каждый элементарный автомат представляет то или иное физическое явление в твердом теле, а ребра графа описывают взаимовлияния.

Отдельно стоит упомянуть проекты использования квантовых процессов в твердых телах. Чтобы не связываться с техническими трудностями получения и поддержания экстремально низких температур, многие исследователи занялись разработкой приложений квантовой оптики твердых сред, большинство явлений которой протекают при обычных температурах. Вероятно, самым поразительным результатом этих работ можно считать фотонные кристаллы — искусственно синтезированные твердотельные структуры, обладающие рядом необъяснимых с позиций классической оптики свойств, а также способностью воспринимать и обрабатывать информацию, «закодированную» в параметрах когерентного оптического сигнала. Однако инженерные методики конструирования вычислительных сред на базе фотонных кристаллов еще предстоит создать. — Ю.Р.

Меж нулем и единицей

54 года — и все тот же «принцип арифмометра»…

Впрочем, грех жаловаться — этот принцип оказался столь гибким в приложениях, что даже принципиально новые идеи вычислительных устройств (например, нейроподобные сети или системы с нечеткой логикой) вначале реализуются в виде программ для «обычных» компьютеров. Зачастую они в этом виде так и остаются навсегда… Все это наводит на мысль, что, возможно, «компьютеры послезавтрашнего дня» с точки зрения «железа» не будут чем-то особенным отличаться от нынешних, но вот процессы, протекающие в их недрах, скорее всего, будут совсем другими.Вот об этих «других процессах» мы и поговорим.

Цифра или не цифра?

Аналоговые вычислительные машины (АВМ), как известно, устроены не по принципу арифмометра. Обрабатываемая информация в них представляется теми или иными физическими величинами — чаще всего электрическими: напряжением, током, сопротивлением, реже — частотой или интервалами времени. Однако во всех случаях это измеряемые величины, которые доступны непосредственному измерению при помощи прибора.Кроме измеряемых величин, физические процессы характеризуются также вычисляемыми параметрами, которые недоступны непосредственному измерению прибором и в то же время не всегда сводимы к простым процедурам арифметических манипуляций с измеряемыми величинами. Вычисляемые параметры тоже являются аналоговыми величинами, так как могут непрерывно приобретать любые, сколь угодно мало отличающиеся друг от друга значения. Принципиально важно, что эти величины тоже могут быть носителями информации, подлежащей обработке или запоминанию.

Обратим внимание на одну из богатейших по своим информационным возможностям аналоговую вычисляемую величину — вероятность. Именно то, что вероятность всегда вычисляется и предстает перед нами в виде цифры, маскирует ее аналоговую «сущность».

Отметим также, что вероятность наступления какого-то события (например, переключения триггера) как величина или параметр, характеризующий какой-либо физический процесс, объективно существует даже тогда, когда мы ее не знаем или не можем вычислить. Это очень важное замечание! Постепенное осознание этого обстоятельства позволило в течение тридцатилетней истории работ над вероятностными вычислителями прийти к принципиально новым идеям в этой области; впрочем, об этом поговорим чуть позже.

В 1970-х годах начались активные теоретические исследования и разработки так называемых стохастических вычислительных машин, основанных на вероятностном представлении информации. Переменные и константы в этих аналоговых машинах представлялись вероятностями переключения цифровых логических элементов. Другими словами, информация кодировалась вероятностью, которая в силу своих фундаментальных свойств может принимать непрерывный ряд значений в интервале от 0 до 1.

Архитектура стохастических вычислителей в общем-то повторяла решения, разработанные для аналоговых вычислительных машин: программирование сводилось к набору структурной схемы из решающих блоков, которые в отличие от АВМ были построены не на операционных усилителях, а на логических элементах. Подкупала простота технической реализации вычислителя: замена операций над числами операциями над вероятностями позволила воспользоваться глубокими аналогиями, существующими между аппаратом событийной теории вероятности и принципами математической логики; так, например, операция умножения вероятностей независимых событий формально полностью совпадает с логической операцией конъюнкции, а суммированию вероятностей соответствует операция дизъюнкции. Эти аналогии позволяют считать логические переменные некоторыми случайными событиями, имеющими определенные вероятности появления. С инженерной точки зрения это означает, например, что один логический элемент ИЛИ (дизъюнкция) становится сумматором, а единственный элемент И (конъюнкция) превращается в умножитель!

Этот подход оказался особенно хорош для создания специализированных процессоров, рассчитанных на непрерывное вычисление, предположим, управляющего воздействия в системах управления. Будучи «по природе» аналоговым, такой вычислитель мог решать задачи в реальном времени независимо от объемов вычислений; а будучи цифровым (по элементной базе), он был лишен таких принципиальных недостатков обычных АВМ, как дрейф нуля и шумы операционных усилителей, а также наводок в сигнальных цепях.

Появление широко доступных БИС ПЛИС(Программируемая Логическая Интегральная Схема, еще называется ПЛМ — Программируемая Логическая Матрица) и БМК(Базовый Матричный Кристалл. Обычно отличается от ПЛИС (ПЛМ) наличием на кристалле большого набора базовых элементов ввода-вывода, аналого-цифровых и цифро-аналоговых преобразователей, контроллеров стандартных интерфейсов и т. д.) позволило реализовать на одном кристалле довольно сложные схемы стохастических вычислителей, однако широкого распространения они не получили — сказался главный недостаток этой технологии (как и вообще всех аналоговых технологий): неудобство перепрограммирования и слишком сильная «привязка» исполняемого алгоритма к аппаратной части.

«Принцип арифмометра» победил — наступила эпоха универсальных цифровых вычислителей.

Принцип матрешки

Пытаясь представить облик процессора будущего, я постоянно боролся с соблазном начать фантазировать. Еще бы: тут тебе и квантовые вычисления, и ДНК-вычислители, и белковая логика… Квантовые процессоры я бы выделил в отдельную категорию — по единственной причине: им присущи принципиально отличные от других механизмы обработки информации. Все остальное — те же «арифмометры»…Короче говоря, если в качестве «послезавтрашнего компьютера» вообразить некий «черный ящик», то становится ясно, что дело не в том, на какой элементной базе он построен, а в том, что построено. Какая обрабатывающая среда находится внутри «ящика»?

Вообще, понятие «обрабатывающая среда» довольно абстрактно. Практически это может быть физическая среда, свойства которой дают ей возможность производить вычисления. Кусок стекла, которому придана форма линзы, — уже вычислитель! Он «умеет» вычислять Фурье-преобразование оптических сигналов… Но вот беда: существует так называемый критерий физической реализуемости. В частности, он означает, что не для всякого вычисления можно подобрать (или создать) соответствующую физическую среду. Но даже если критерий физической реализуемости удовлетворяется, практически создать необходимую среду невероятно трудно!

Гораздо продуктивнее моделировать обрабатывающие среды в цифровом виде. Чтобы сделать это, мы должны взять цифровой процессор (любой! хоть арифмометр) и написать для него программу, эмулирующую информационные процессы и структуру нужной нам обрабатывающей среды. Тем самым мы как бы создаем «виртуальную оболочку» вокруг обрабатывающей среды физического уровня, в качестве которой выступает процессор. Что при этом происходит? А вот что: мы преодолеваем критерий физической реализуемости.

Следующий важный вопрос, мимо которого не пройти: что мы хотим получить? Если под «процессором будущего» понимать просто «ну очень быстрый процессор», то, думается, за этим дело не станет. Но, видимо, мы хотим чего-то большего… Чего?

Честный ответ: хотелось бы создать модель себя. По крайней мере, в части восприятия и обработки приходящей извне информации.

А что это значит, если говорить языком технического задания?

Во-первых, быстродействие. Производительность цифровых процессоров зависит от частоты, разрядности и распараллеливания вычислительных процессов. У аналоговых вычислителей таких ограничений нет, но есть много своих специфических «минусов» и существует упоминавшийся выше критерий реализуемости (поскольку аналоговый процессор — это, собственно, физическая обрабатывающая среда «в чистом виде»). А что, если окружить цифровой процессор виртуальной аналоговой «оболочкой»? Из чего ее сделать? Вариант ответа: эта «оболочка» может представлять собой стохастический вычислительный процесс, оперирующий вероятностями, и тогда отпадают ограничения по быстродействию!

Во-вторых, отсутствие необходимости в программировании. Раз нет программирования, следовательно — самообучение? Да. Нейроподобные сетевые структуры. Об их свойствах написаны горы книг, однако сейчас имеет смысл отметить следующее: нейросети — аналоговые обрабатывающие среды, которые мы давным-давно научились реализовывать в качестве «оболочек» над цифровыми процессорами, но… Но при этом нейросети, реализованные в форме программ, оперирующих цифровыми входными сигналами, сами становятся цифровыми, теряя в быстродействии и в качественных показателях. Один из перспективных вариантов разрешения этого противоречия заключается в создании стохастических нейроалгоритмов, позволяющих сохранять аналоговые принципы функционирования нейросетей при цифровом моделировании(Большая работа в этом направлении проводилась в Киевском институте кибернетики им. В. М. Глушкова под руководством академика Н. М. Амосова, в частности, Э. М. Куссулем, А. М. Касаткиным, Л. М. Касаткиной, Т. В. Федосеевой).

В-третьих, отсутствие жестких алгоритмов функционирования — свойство, открывающее возможности адаптивного поведения и динамического целеполагания. Исследования в этом направлении, проводившиеся у нас и за рубежом, показали, что глубинная суть этих процессов с достаточной степенью адекватности описывается лишь аппаратом теории динамического хаоса. Иными словами, чтобы воссоздать «на практике» обрабатывающую среду, обладающую требуемым «поведением», необходимо либо каким-то образом синтезировать ее «в железе», либо смоделировать нужный тип нелинейной динамики. Во втором случае для этого легче всего использовать все те же стохастические нейросети или матрицы вероятностных клеточных автоматов.

По существу, создавая нейросетевую модель нелинейной динамической системы с нужным нам поведением (не детерминированным, а в среднем!), мы тем самым создаем еще одну «оболочку» — уже вторую! — над исходной физической обрабатывающей средой — цифровым процессором.

Портрет героя

Впечатляющей футуристической картины под названием «Процессор будущего» не получилось. Жаль, если я кого-то разочаровал. Но мне действительно представляется маловероятным резкий (с чего бы вдруг?! И у кого?) рост интереса к созданию каких-то принципиально новых обрабатывающих сред физического уровня — электронных, биологических и даже квантовых.Гигантский прогресс технических характеристик обычных микропроцессоров и, что особенно важно, накопление огромного арсенала средств разработки — как самих микросхем, так и программного обеспечения всех уровней, — как мне кажется, породили своеобразную «потенциальную яму», «выпрыгнуть» из которой чрезвычайно трудно — нужно много энергии, аналогом которой в данном случае выступают деньги.

Впрочем, всегда есть ненулевая вероятность «туннельного просачивания» сквозь стенки любых потенциальных ям. И для этого, как известно, не нужно много той самой «энергии»!

Практичная теория: день открытых дверей в творческой лаборатории изобретателя

«Физические эффекты и явления — костяк той самой физики, которую современный изобретатель годами изучает в школе и в институте. К сожалению, изобретательскому применению физики там не учат… Изобретателям надо присматриваться к давно знакомым эффектам и явлениям, приучаясь видеть в них рабочие инструменты для творческого решения изобретательских задач».

Генрих Альтшуллер, «Алгоритм изобретения»

Начну с главного тезиса. Все технические системы, устройства и приборы были кем-то изобретены.

Поэтому, когда мне было предложено рассказать о «технологии изобретания» компьютерных устройств послезавтрашнего дня, да еще основанных на новых физических принципах, я понял, что меня провоцируют. По существу, мне предлагалось поиграть в деловую игру «Назвался груздем…»[Автор является руководителем семинара по ТРИЗ]. В первый момент, каюсь, «взыграло»… Короче говоря, я отбросил тщеславные попытки практически изобрести невиданный процессор, а попытался рассказать о возможных подходах к решению этой задачи, основанных на ТРИЗ — Теории Решения Изобретательских Задач, созданной нашим талантливым соотечественником Генрихом Сауловичем Альтшуллером.

Надо сказать, что изобретательские задачи часто путают с задачами научными, техническими, инженерными или конструкторскими. Если мы, имея комплект чертежей топологии, расчеты технологических параметров и таблицы контрольных значений тестовых сигналов, собираемся изготовить микросхему, то это будет технической задачей. Расчет электронной схемы или теплового режима, предположим, полупроводникового лазера по готовым формулам и методикам — задача инженерная. Поиск этих формул и получение методик — типично научная задача. Поиск компромиссов между функциональностью чипа и его площадью на кристалле — суть задача конструкторская. Решение всех этих задач не связано с преодолением каких-то противоречий. Задача становится изобретательской только тогда, когда возникает необходимость одолеть несовместимость[Альтшуллер Г.С., Творчество как точная наука, М., «Советское радио», 1979 г. См. также: Альтшуллер Г.С., Алгоритм изобретения, М., «Московский рабочий», 1973 г.].

Итак. Какие же действительно несовместимые технические характеристики мы ожидаем встретить в процессоре будущего?

Функциональность и простота в использовании. Преодолением этого противоречия постоянно заняты разработчики программного обеспечения[По Г.С. Альтшуллеру, это конструкторская задача]. И, надо сказать, им это неплохо удается, но… В окружающей природе полно примеров очень функциональных и очень простых в использовании «вычислительных устройств»[Мяукающих, гавкающих, чирикающих и т. п. И говорящих, в том числе. Увы], которые вообще не нужно программировать! Их нужно дрессировать, то есть передавать им представления о том, как им себя вести. А программы такого поведения они создают для себя сами. Это мы возьмем на заметку.

Функциональность и размеры… Сразу вспоминаются квантовые процессоры. Новые физические принципы — налицо, экстремально малые размеры собственно «вычислителя» и — в «нагрузку» — кубометры холодильной техники, лазеров и соленоидов. А почему, собственно, нас так интересуют размеры? Мы что, материал экономим? А если поступим так: выведем в околоземный космос несколько тысяч могучих серверов на спутниках, объединим их в сеть, а на локальные машины возложим лишь отправку «наверх» запросов да исполнение команд. Функциональность — выше некуда, а размеры «клиентов» будут под стать их назначению — думаю, не больше мобильного телефона…

Вы чувствуете, как над нами довлеет инерция мышления?

Это она не позволяет нам представить себе вычислитель, который не вычисляет… Большую систему, которая не занимает места… Сложную и одновременно очень простую… Вот они! Действительные противоречия, составляющие предмет изобретательской деятельности!

Калиновский [ar_ka@ua.fm]

Без лишних деталей

Дмитрий Аркадьевич Лежаков — мой собеседник — в недалеком прошлом представитель двигателестроительной 'оборонки'. Занимался он математическим моделированием аэро— и гидродинамических процессов. В настоящее время преподает в авиационном вузе. Я дал ему прочитать ранее подготовленные материалы темы номера, и они его сильно взволновали. Не своим содержанием, а 'беспросветным оптимизмом' авторов, по выражению Дмитрия Аркадьевича.

Вы с самого начала поняли, что ваше призвание — математическое моделирование физических процессов?

— Нет, дело в том, что я всегда хотел знать, над чем я работаю. На режимных предприятиях когда-то было заведено так, что каждый выполнял только порученную ему работу, а для чего это? куда это пойдет? — мало, кто знал. Поэтому, еще в институте, я понял, что нужно становиться 'управленцем', специалистом по управлению процессами — чтобы управлять изделием, его сначала нужно до тонкостей изучить. А лучший способ изучить — написать матмодель. В общем, применил 'военную хитрость'…

Много лет вы наблюдали, как совершенствуется техника, как становится все сложнее…

— Вы имеете в виду конструктивную сложность? Далеко не всегда. А если говорить, например, о такой технике, как авиационные двигатели, так и подавно. Поршневые моторы последних выпускавшихся типов чрезвычайно сложны в конструктивном плане! Первые пришедшие им на смену турбореактивные двигатели с центробежными компрессорами были, наоборот, очень простыми. Проектировать их, правда, гораздо труднее. Рассчитывать режимы… Там много тонких моментов, связанных с неустойчивостью работы компрессора, камер сгорания, там нужно заботиться о геометрии сопла…

Но, в общем, постепенно начинается конструктивное усложнение. То одна деталь добавляется, то другая. Стоимость, конечно, растет. Осевой компрессор — вообще очень сложная и дорогая штука. Но если мы возьмем какой-то новый физический принцип, то зачастую на его основе можно создать конструктивно более простое изделие. Принцип прямоточного двигателя, например. В нем нет ни одной вращающейся детали!

Но 'на земле' такие двигатели не работают…

— Дело не в этом. Главное, что в 'прямоточнике' мы заменили механическую деталь физическим процессом! Как вы думаете, что надежнее? Можете ли вы представить, чтобы при каких-то условиях 'вышла из строя' ударная волна? Скачок уплотнения? Или чтобы ее 'заклинило'? Или чтобы она 'поломалась' из-за температурных напряжений?

Вот это — главное! Но теоретические и расчетные трудности здесь очень велики. Такой двигатель представляет собой чрезвычайно простое в конструктивном плане изделие, но чрезвычайно сложное — как 'конструкция', состоящая из протекающих в нем физических процессов. Вот почему я привожу этот пример. Мы берем новый физический принцип и — р-раз! Видим, что наше устройство стало конструктивно проще. Там стало меньше деталей. Потом начинаются усовершенствования, доработки… Конструкция усложняется, опять становится много деталей… И в какой-то момент надо брать новый принцип, который вновь приведет к тому, что половину деталей можно будет выбросить без ущерба для функциональности. Короче говоря, используемые физические принципы становятся все более сложными, трудно их рассчитывать, трудно строить модели, но конструктивно изделия становятся проще! Это страшно красиво!

Вы говорите, что прямоточные двигатели не работают на земле… Что ж, сегодня это так. А что будет завтра? Когда в прошлом году я прочитал статьи об испытаниях Х-43А[27 марта 2004 г. на полигоне в Калифорнии успешно прошел испытательный полет экспериментального гиперзвукового беспилотного самолета NASA Х-43А. В качестве двигателя в нем использовался ГПВРД — гиперзвуковой прямоточный воздушно-реактивный двигатель. Достигнутая скорость — 7М (в семь раз быстрее звука, 8350 км/час). — Ю.Р.] и особенно о тех трудностях, которые удалось преодолеть инженерам из NASA, когда потребовалось синтезировать расчетным путем геометрию газовоздушного тракта, способную в динамике реализовать законы управления процессами горения, вообще — термодинамическим циклом двигателя, я был в восторге! Там знаете сколько разных процессов одновременно происходит! И это при высоких давлениях и температурах, а значит — сплошные нелинейности и взаимовлияния. Колоссальные сложности для моделирования…

Какие трудности стоят на пути отечественных создателей техники будущего?

— Думаете, буду жаловаться, что денег не хватает? Нет, про деньги говорить не буду. На мой взгляд, есть гораздо более серьезная проблема. Еще несколько лет назад ее не было, а сегодня — уже есть, обозначилась…

Падает уровень технического образования?..

— Да, многие об этом говорят, но их не слышат. Или не очень громко говорят… Принято ведь считать, что наши вузы готовят невероятно грамотных специалистов. Товарищи ученые, доценты с кандидатами… Ну нельзя же так обманывать себя!

Техника завтрашнего дня будет конструироваться при помощи такой лютой математики, что… И физику нужно знать не 'вообще', а 'конкретно'. Чтобы ее так узнать, с ней нужно возиться в лабораториях! Нужно ее 'через руки' пропускать! У нас нет таких лабораторий… А в математике нужна практика, как в иностранных языках. Если не решаешь задачи — быстро дисквалифицируешься. По себе сужу — два года не работал (так обстоятельства сложились), так еле-еле мозги 'размял'!

Вы с самого начала поняли, что ваше призвание — математическое моделирование физических процессов?

— Нет, дело в том, что я всегда хотел знать, над чем я работаю. На режимных предприятиях когда-то было заведено так, что каждый выполнял только порученную ему работу, а для чего это? куда это пойдет? — мало, кто знал. Поэтому, еще в институте, я понял, что нужно становиться 'управленцем', специалистом по управлению процессами — чтобы управлять изделием, его сначала нужно до тонкостей изучить. А лучший способ изучить — написать матмодель. В общем, применил 'военную хитрость'…

Много лет вы наблюдали, как совершенствуется техника, как становится все сложнее…

— Вы имеете в виду конструктивную сложность? Далеко не всегда. А если говорить, например, о такой технике, как авиационные двигатели, так и подавно. Поршневые моторы последних выпускавшихся типов чрезвычайно сложны в конструктивном плане! Первые пришедшие им на смену турбореактивные двигатели с центробежными компрессорами были, наоборот, очень простыми. Проектировать их, правда, гораздо труднее. Рассчитывать режимы… Там много тонких моментов, связанных с неустойчивостью работы компрессора, камер сгорания, там нужно заботиться о геометрии сопла…

Но, в общем, постепенно начинается конструктивное усложнение. То одна деталь добавляется, то другая. Стоимость, конечно, растет. Осевой компрессор — вообще очень сложная и дорогая штука. Но если мы возьмем какой-то новый физический принцип, то зачастую на его основе можно создать конструктивно более простое изделие. Принцип прямоточного двигателя, например. В нем нет ни одной вращающейся детали!

Но 'на земле' такие двигатели не работают…

— Дело не в этом. Главное, что в 'прямоточнике' мы заменили механическую деталь физическим процессом! Как вы думаете, что надежнее? Можете ли вы представить, чтобы при каких-то условиях 'вышла из строя' ударная волна? Скачок уплотнения? Или чтобы ее 'заклинило'? Или чтобы она 'поломалась' из-за температурных напряжений?

Вот это — главное! Но теоретические и расчетные трудности здесь очень велики. Такой двигатель представляет собой чрезвычайно простое в конструктивном плане изделие, но чрезвычайно сложное — как 'конструкция', состоящая из протекающих в нем физических процессов. Вот почему я привожу этот пример. Мы берем новый физический принцип и — р-раз! Видим, что наше устройство стало конструктивно проще. Там стало меньше деталей. Потом начинаются усовершенствования, доработки… Конструкция усложняется, опять становится много деталей… И в какой-то момент надо брать новый принцип, который вновь приведет к тому, что половину деталей можно будет выбросить без ущерба для функциональности. Короче говоря, используемые физические принципы становятся все более сложными, трудно их рассчитывать, трудно строить модели, но конструктивно изделия становятся проще! Это страшно красиво!

Вы говорите, что прямоточные двигатели не работают на земле… Что ж, сегодня это так. А что будет завтра? Когда в прошлом году я прочитал статьи об испытаниях Х-43А[27 марта 2004 г. на полигоне в Калифорнии успешно прошел испытательный полет экспериментального гиперзвукового беспилотного самолета NASA Х-43А. В качестве двигателя в нем использовался ГПВРД — гиперзвуковой прямоточный воздушно-реактивный двигатель. Достигнутая скорость — 7М (в семь раз быстрее звука, 8350 км/час). — Ю.Р.] и особенно о тех трудностях, которые удалось преодолеть инженерам из NASA, когда потребовалось синтезировать расчетным путем геометрию газовоздушного тракта, способную в динамике реализовать законы управления процессами горения, вообще — термодинамическим циклом двигателя, я был в восторге! Там знаете сколько разных процессов одновременно происходит! И это при высоких давлениях и температурах, а значит — сплошные нелинейности и взаимовлияния. Колоссальные сложности для моделирования…

Какие трудности стоят на пути отечественных создателей техники будущего?

— Думаете, буду жаловаться, что денег не хватает? Нет, про деньги говорить не буду. На мой взгляд, есть гораздо более серьезная проблема. Еще несколько лет назад ее не было, а сегодня — уже есть, обозначилась…

Падает уровень технического образования?..

— Да, многие об этом говорят, но их не слышат. Или не очень громко говорят… Принято ведь считать, что наши вузы готовят невероятно грамотных специалистов. Товарищи ученые, доценты с кандидатами… Ну нельзя же так обманывать себя!

Техника завтрашнего дня будет конструироваться при помощи такой лютой математики, что… И физику нужно знать не 'вообще', а 'конкретно'. Чтобы ее так узнать, с ней нужно возиться в лабораториях! Нужно ее 'через руки' пропускать! У нас нет таких лабораторий… А в математике нужна практика, как в иностранных языках. Если не решаешь задачи — быстро дисквалифицируешься. По себе сужу — два года не работал (так обстоятельства сложились), так еле-еле мозги 'размял'!